出典: 量子ビット清華 **Tang Jie** チームの新作はこちらです:**WebGLM**、100 億のパラメータを持つ **インターネットワーク**の質疑応答チャット ロボット (この論文は KDD2023 に選ばれました)。 任意の質問をすることができ、インターネット上の関連記事 (Wikipedia、関連公式 Web サイトなど) へのリンクを一覧表示し、回答を整理します。例えば:> ChatGPTのコア技術は何ですか? または:> Music Transformer を提案したのは誰ですか?その原理は何ですか? または:> 原神3.5はどうですか?> 高収入の仕事がなければ、どうやって一級都市で生活できるのでしょうか? (手動ドッグヘッド) ……それは合理的な答えを与えることができます。レポートによると、WebGLM の性能比較テストでは**OpenAI の 135 億パラメータの WebGPT** を上回るレベルであり、人間による評価では 1750 億パラメータのモデルにも匹敵するという結果が出ています。 では、どのように訓練されるのでしょうか?## **インターネットにアクセスできる清華省 WebGLM**レポートによると、WebGLM の目標は、効率的な実際のデプロイメントを可能にしながら、Web 検索および取得機能を通じて事前トレーニングされた大規模言語モデルを強化することです。そのために著者は**3つの戦略**に基づいて開発を行っています。1 つ目は **大型モデルのオーグメンテッド レトリバー**です。これは主に、モデル関連のネットワーク コンテンツの検索能力を強化し、特定のクエリの場合に関連する参照を見つけて、後で質問に正確に答えるために使用されます。これには、粗粒度の Web 検索と、粒度の細かい LLM 拡張高密度検索の 2 つの段階があります。続いて **ブートストラップ ジェネレーター**。GLM の機能 (清華大学がリリースしたバイリンガル オープンソース事前トレーニング モデル GLM-130B など) を使用して、質問に対する回答を生成し、詳細な回答を提供します。このジェネレーターを使用して、著者らは WebGLM-QA (LLM ブートストラップ引用および長距離 QA データセット) を取得します。コンテキスト学習などの戦略を通じてクリーン化およびフィルタリングされ、最終的に 45,000 の高品質のフィルタリングされたサンプルと 83,000 のノイズ サンプルが含まれます。WebGLM のバックボーンは、このデータセットでトレーニングされた GLM モデルです。最後に、人間の好みに基づいたスコアラーがあります。コストのかかる専門家からのフィードバックよりも人間の好みを優先することで、生成された応答の品質を評価し、システムが有用で魅力的なコンテンツを確実に生成できるようにします。上記の 3 つのコンポーネントは、最終的に次の順序で WebGLM のパイプラインを形成します。 上記で紹介した 3 つの部分に対応する、正確に 3 つのモジュールがあることがわかります。その中には次のものがあります。LLM 拡張取得機能は、**最も関連性の高いページ** を参照ソースとして使用し、ブートストラップ ジェネレーターに複数の回答を生成させ、最後にスコアラーが最終出力として人間の好みを満たす可能性が最も高いページを選択します。## **パフォーマンスは OpenAI WebGPT を超えます**Tang Jie 氏のチームは、WebGLM 自体に加えて、ネットワーク強化型質問応答システムの評価基準も提案しており、評価対象には参考資料と最終回答の両方が含まれます。このうち、前者は関連性、情報密度、信頼性(事実誤認がないこと)、有害性(暴力ポルノなどの情報を除く)、社会的偏見の度合いの5つの側面を測定し、後者は流暢性、正確性、引用の正確性、客観性を測定します。 .そして冗長性。彼らは、比較評価のために WebGPT (OpenAI から、GPT-3 に基づいて微調整された) デモ Web サイトによって提供される 272 の質問を使用し、採点のために修士号を持つ 15 人のボランティアを募集しました。最終的な結果は次のとおりです。 (「Rel.」、「Den.」・・・それぞれ上記10個の指標に対応します。)WebGLM の検索結果は、WebGPT-175B には若干劣るものの、Perplexity.ai や WebGPT-13B よりはかなり優れていることがわかります (左の参考評価)。WebGLM の取得プロセスでは、いくつかの従来の単語ベースのアルゴリズムと、累積パラメーターが 300M を超えない 2 つの Contriever のみが使用されることに注意してください。さらに、WebGLM はコンピューティング パフォーマンスと消費時間の点でも WebGPT-13B よりも大幅に優れており、175B に匹敵します。最終結果に関しては、WebGLM が流暢性、信頼性、冗長性の点で最高のスコアを達成し、その正確性指数は WebGPT-175B に近く、Perplexity.ai や WebGPT-13B よりもはるかに高かった。著者らによれば、これは WebGLM が低コストでより高いパフォーマンスを達成できることを示しています。## **導入とトレーニング**WebGLM **はオープンソース**としてリリースされています。 これをデプロイするには、SerpAPI 公式 Web サイトからキーを取得する必要があります。このキーは、検索プロセス中に検索結果を取得するために使用されます。レトリーバーの体重は清華雲からダウンロードできます。モデルを実行するには 2 つの方法があります。1 つはコマンド ライン インターフェイス、もう 1 つは Web サービスの形式です。**WebGLM-2B と WebGLM-10B** を含む 2 つのオプション モデルがあります。WebGLM を自分でトレーニングすることもできます。ジェネレーターとレトリーバーの公式トレーニング データがダウンロード用に提供されています~用紙のアドレス:GitHub ホームページ:

Tsinghua Tang Jie の新作 WebGLM: 100 億パラメータ、主にオンライン検索、パフォーマンスは OpenAI WebGPT を超える

出典: 量子ビット

清華 Tang Jie チームの新作はこちらです:

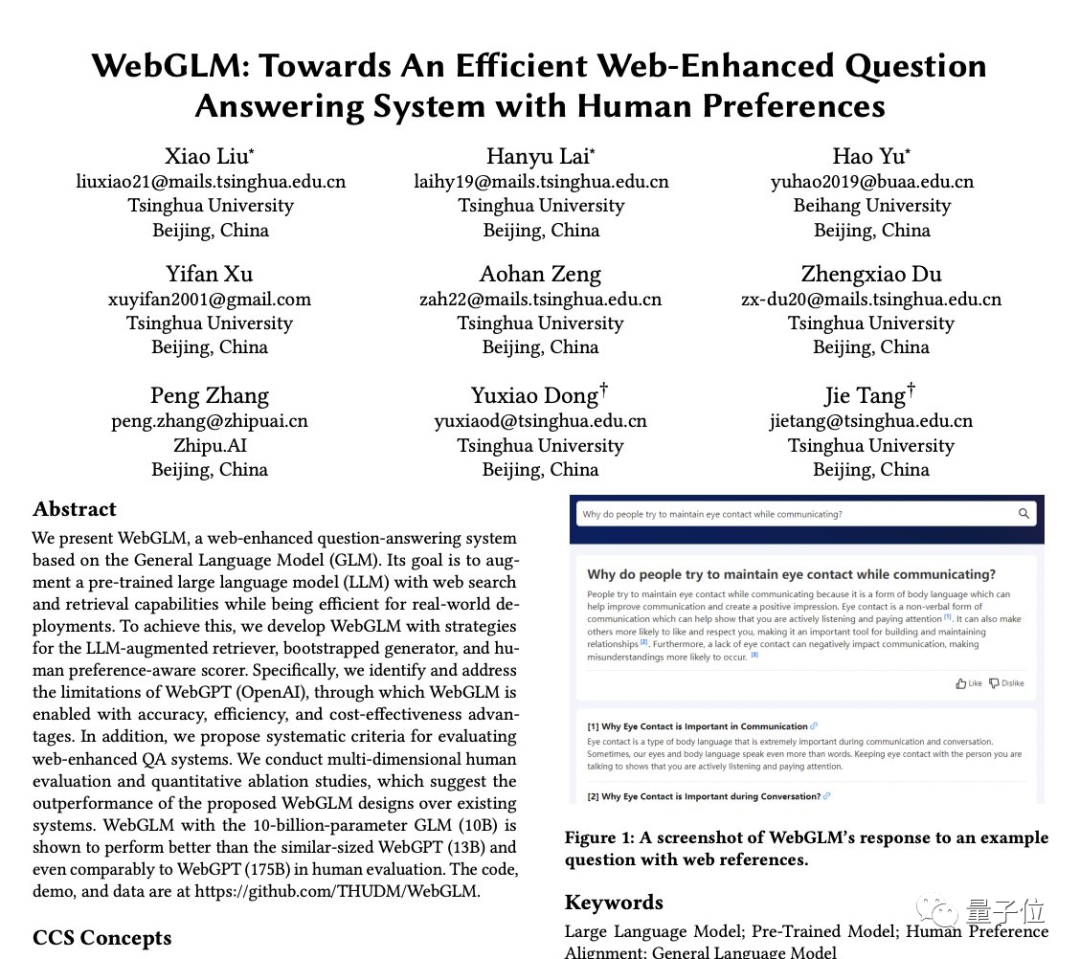

WebGLM、100 億のパラメータを持つ インターネットワークの質疑応答チャット ロボット (この論文は KDD2023 に選ばれました)。

例えば:

それは合理的な答えを与えることができます。

レポートによると、WebGLM の性能比較テストではOpenAI の 135 億パラメータの WebGPT を上回るレベルであり、人間による評価では 1750 億パラメータのモデルにも匹敵するという結果が出ています。

インターネットにアクセスできる清華省 WebGLM

レポートによると、WebGLM の目標は、効率的な実際のデプロイメントを可能にしながら、Web 検索および取得機能を通じて事前トレーニングされた大規模言語モデルを強化することです。

そのために著者は3つの戦略に基づいて開発を行っています。

1 つ目は 大型モデルのオーグメンテッド レトリバーです。

これは主に、モデル関連のネットワーク コンテンツの検索能力を強化し、特定のクエリの場合に関連する参照を見つけて、後で質問に正確に答えるために使用されます。

これには、粗粒度の Web 検索と、粒度の細かい LLM 拡張高密度検索の 2 つの段階があります。

続いて ブートストラップ ジェネレーター。

GLM の機能 (清華大学がリリースしたバイリンガル オープンソース事前トレーニング モデル GLM-130B など) を使用して、質問に対する回答を生成し、詳細な回答を提供します。

このジェネレーターを使用して、著者らは WebGLM-QA (LLM ブートストラップ引用および長距離 QA データセット) を取得します。

コンテキスト学習などの戦略を通じてクリーン化およびフィルタリングされ、最終的に 45,000 の高品質のフィルタリングされたサンプルと 83,000 のノイズ サンプルが含まれます。

WebGLM のバックボーンは、このデータセットでトレーニングされた GLM モデルです。

最後に、人間の好みに基づいたスコアラーがあります。

コストのかかる専門家からのフィードバックよりも人間の好みを優先することで、生成された応答の品質を評価し、システムが有用で魅力的なコンテンツを確実に生成できるようにします。

上記の 3 つのコンポーネントは、最終的に次の順序で WebGLM のパイプラインを形成します。

LLM 拡張取得機能は、最も関連性の高いページ を参照ソースとして使用し、ブートストラップ ジェネレーターに複数の回答を生成させ、最後にスコアラーが最終出力として人間の好みを満たす可能性が最も高いページを選択します。

パフォーマンスは OpenAI WebGPT を超えます

Tang Jie 氏のチームは、WebGLM 自体に加えて、ネットワーク強化型質問応答システムの評価基準も提案しており、評価対象には参考資料と最終回答の両方が含まれます。

このうち、前者は関連性、情報密度、信頼性(事実誤認がないこと)、有害性(暴力ポルノなどの情報を除く)、社会的偏見の度合いの5つの側面を測定し、後者は流暢性、正確性、引用の正確性、客観性を測定します。 .そして冗長性。

彼らは、比較評価のために WebGPT (OpenAI から、GPT-3 に基づいて微調整された) デモ Web サイトによって提供される 272 の質問を使用し、採点のために修士号を持つ 15 人のボランティアを募集しました。

最終的な結果は次のとおりです。

WebGLM の検索結果は、WebGPT-175B には若干劣るものの、Perplexity.ai や WebGPT-13B よりはかなり優れていることがわかります (左の参考評価)。

WebGLM の取得プロセスでは、いくつかの従来の単語ベースのアルゴリズムと、累積パラメーターが 300M を超えない 2 つの Contriever のみが使用されることに注意してください。

さらに、WebGLM はコンピューティング パフォーマンスと消費時間の点でも WebGPT-13B よりも大幅に優れており、175B に匹敵します。

最終結果に関しては、WebGLM が流暢性、信頼性、冗長性の点で最高のスコアを達成し、その正確性指数は WebGPT-175B に近く、Perplexity.ai や WebGPT-13B よりもはるかに高かった。

著者らによれば、これは WebGLM が低コストでより高いパフォーマンスを達成できることを示しています。

導入とトレーニング

WebGLM はオープンソースとしてリリースされています。

レトリーバーの体重は清華雲からダウンロードできます。

モデルを実行するには 2 つの方法があります。1 つはコマンド ライン インターフェイス、もう 1 つは Web サービスの形式です。WebGLM-2B と WebGLM-10B を含む 2 つのオプション モデルがあります。

WebGLM を自分でトレーニングすることもできます。ジェネレーターとレトリーバーの公式トレーニング データがダウンロード用に提供されています~

用紙のアドレス:

GitHub ホームページ: