2023 年、投資機関と株主は AI チップ分野の上場企業に 3 つの致命的な質問をしています。ストレージと計算を統合したチップはもう作りましたか?(Montage Technology に質問した投資家の情報源: 通化順金融)メモリコンピューティング統合チップの進歩はどうですか?(投資家ら東新株への質問元:通華順金融)ストレージとコンピューティング チップの統合にはどのような見通しがありますか?(恒朔株に対する投資家の質問の出典: 通化順金融)上記の一連の質問は、ストレージと計算の統合がもはや学界や産業界に「とどまる」ものではなく、流通市場で人気があるようであることを意味します。株主や証券会社は、ストレージと計算の統合を補うために残業をしています。ストレージとコンピューティングの統合のため、従来のチップメーカーは 2023 年の初め以来、ストレージとコンピューティングの統合レイアウトを「苦しめ」てきました。当然の疑問は、なぜ預金と計算の統合が突然これほど普及したのかということです。7.14に新ストレージ製品OceanStor A310をリリースしたファーウェイは、独自の答えを出した。ファーウェイのデータストレージ製品ラインの社長、周岳峰氏は、汎用大規模モデルや業界大規模モデルのトレーニングと推論には多くのデータ問題があると述べた。つまり、大量のデータのクロスドメイン収集が遅い、前処理や処理におけるデータインタラクションの効率が低い、というものだ。トレーニング、および困難なデータ フロー セキュリティ。大規模な AI モデルは、従来の AI よりも安定性が劣るなど、ストレージに新たな課題をもたらしますが、同時に、大量のデータの前処理と準備作業が発生し、ストレージに近いコンピューティング (一種のAI) が必要になります。ストレージと計算)を使用して、この問題に体系的に対処します。では、ここで言う「大量のデータ」とはどれくらいなのでしょうか? SI Rui Insightの計算によると、ChatGPTのユーザー数は現在1日あたり1億人で、このうち5%の人が毎日同じ時間に毎秒質問すると、三峡ダムの発電量を1年近く食いつぶすことになる。言い換えれば、大規模モデルはコンピューティング能力を猛烈に要求しており、ストレージとコンピューティングの統合に代表される新たなソリューションは、大規模モデルによってもたらされる多くの課題を解決できるということです。実際、この大型モデルはコンピューティング能力に厳しい要件を課していることに加えて、AI チップメーカーに「多量の砂糖」を与えています。この記事では、大規模モデルの背景の下で、AI チップ メーカーにどのようなメリットがあるのかを探っていきます。 ChatGPTによって「解雇」されたストレージとコンピューティングの統合メーカーは今後どのようなパターンになるのでしょうか?**PART-01 「幸と不幸はお互いに依存する」AIチップメーカー**モックアップの風は今も吹き続けており、モックアップに関する議論はまだ真っ盛りだ。8月初旬、中国コンピュータ連盟(CCF)人工知能会議のサブフォーラム「崑崙AIの大規模モデルコンピューティングパワーの最前線を探る」で、専門家と学者は、大規模モデルの時代には次の点で同意した。モデル、インテリジェントなコンピューティング能力は「希少資産」となっており、コンピューティング リソースをどのように有効活用し、そのメリットを最大化するかが、すべての参加者が直面しなければならない課題となっています。GPT-3 単独で要求される計算能力の量に関しては、控えめな状況下では、三峡ダムは以下を満たすために徹夜で「稼働」する必要があります。同時にオンラインに 1 億人がいると仮定すると、そのうちの 5% が毎日同じ時間に毎秒質問し、それぞれが 30 個のトークンを占有し、推論コンピューティング能力を提供するには 1,530 万個の H100 チップが必要になります。各 H100 の消費電力は 750 W です。1 日 10 時間稼働した場合、これらの H100 チップが配置されているデータセンターの年間消費電力は 840 億 kW*h に達し、三峡ダムの年間発電量は 840 億 kW*h に達します。 882億kW*h。AI チップ メーカーをさらに不安にさせるのは、これが推論段階の大規模な ChatGPT モデルの消費電力にすぎないことです。その結果、統合ストレージとコンピューティング、チップレット、HBM などの一連の新しいソリューションがメーカーによって発掘されています。その中で、ストレージとコンピューティングの統合は、従来のフォン・ノイマン・アーキテクチャの下でのストレージの壁を打ち破ったため、実際にコスト削減と効率向上を実現し、今年の「Ziweixing」となりました。(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)AI チップ メーカーに息吹を与えた新たなソリューションの出現に加え、このビッグ モデルはチップ メーカー、特に新興チップ メーカーに朗報ももたらします。それは、ソフトウェア エコロジーの重要性が低下しているということです。初期のテクノロジーが十分に成熟していなかったとき、研究者は特定の問題を解決することから始めることしかできず、パラメーターが 100 万未満の小さなモデルが生まれました。たとえば、Google が所有する AI 企業 DeepMind は、AlphaGO が何百万人もの人間のプロ プレイヤーのチェスの手順について特別な「学習」を行うことを許可しています。小型モデルが増えた後は、チップの適応などのハードウェアの問題が差し迫っている。したがって、Nvidia が統合エコロジカル CUDA を発表したとき、GPU+CUDA はすぐにコンピューター サイエンス コミュニティの認識を獲得し、人工知能開発の標準構成になりました。現在、次々と登場している大型モデルはマルチモーダル機能を備え、文字、画像、プログラミングなどを扱え、オフィス、教育、医療など複数の垂直分野もカバーできます。これは、主流のエコロジーに適応することが唯一の選択肢ではないことも意味します。大型モデル用のチップの需要が急増しているとき、チップメーカーは、これまでは 1 ~ 2 個の大型モデルに適応するだけで、複数の小型モデルの注文を完了できた可能性があります。 。言い換えれば、ChatGPTの登場は新興チップメーカーにコーナーで追い抜く機会を提供することになる。これは、AIチップ市場構造が大きく変化することを意味します。もはや個別メーカーの個展ではなく、複数のイノベーターによるグループプレイとなるでしょう。コンピューティング能力が不足し、主流のエコロジーに適応することがもはや必須ではなくなったとき、ストレージとコンピューティングの統合はその光を隠すことはほとんどできません。現時点で、投資するかどうか、そしてどれだけ投資するかがAIチップメーカーが直面する第二の問題となっている。この点に関して、「経験豊富な」チップ大手 NVIDIA が長年にわたって与えた答えは、イノベーションに勇気を持って多額の投資を行うことです。新興技術の研究開発を行うすべてのメーカーは、技術的探求の障害や下流メーカーの意見の相違など、さまざまなレベルで問題に直面することは間違いありません。初期の段階で、将来の発展傾向を最初に予測し、勇気を出して探索のステップを踏み出し、合理的なリソースを投入して挑戦した人が、チャンスを掴むことができます。データセンターの波がまだ圧倒的に押し寄せておらず、人工知能トレーニングがまだニッチな分野であるとき、Nvidia は汎用コンピューティング GPU と統合プログラミング ソフトウェア CUDA の開発に多額の投資を行ってきました。これは Nvidia にとって良い仕事です。コンピューティング プラットフォーム。当時、GPU をプログラマブルにすることは「無駄で損」でした。性能が 2 倍になるかどうかはわかりませんが、製品開発は 2 倍になります。このため、喜んでお金を払う顧客はいません。しかし、単機能のグラフィックス プロセッサは長期的な解決策ではないと予測した Nvidia は、すべての製品ラインに CUDA を適用することを決定しました。Xindongxi と Nvidia China のエンジニアリングおよびソリューション担当シニア ディレクターである Lai Junjie 博士とのインタビューの中で、Lai Junjie 氏は次のように述べました。「コンピューティング プラットフォームのビジョンのために、Huang Renxun 氏は初期の段階で Nvidia の多くのリソースを迅速に動員しました。日々。"先見性と多額の投資により、2012 年に Nvidia はイノベーター賞を受賞しました: 2012 年、深層学習アルゴリズムのコンピューティング パフォーマンスは学界にセンセーションを巻き起こしました。高度なコンピューティング、より多用途で使いやすい生産性ツールとして、 GPU+CUDA は急速に普及し、コンピュータ サイエンス コミュニティでは人工知能開発の「標準構成」になりました。大きなコンピューティング能力を備えた AI チップの歩みの中で、統合ストレージおよびコンピューティング チップは独自の「黄金期」を迎えており、事前の投資が正しい答えです。**PART-02 非技術者、経済的に裕福な方は入場しないでください**ストレージとコンピューティングの統合によるさまざまな利点を考慮して、現段階ではストレージとコンピューティング チップを統合するプレーヤーの陣営が成長しています。(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)CIRUI Insightの不完全な統計によると、2019年以降、ほとんどの新しいAIチップメーカーはストレージとコンピューティングを統合しています。2019年から2021年には20社の新しいAIチップメーカーがあり、そのうち10社はデポジットと計算の統合ルートを選択しています。これらはすべて、ストレージとコンピューティングの統合が GPGPU、ASIC、その他のアーキテクチャに続く新星になることを示しています。そして、この新しいスター、誰もがそれを選ぶことができるわけではありません。学界、産業界、資本がストレージとコンピューティングの統合について一致して楽観的である状況下では、強力な技術力、堅実な人材の確保、移行コストの受け入れの正確な制御が、業界の競争力を維持するための鍵となります。新規参入者にとっての 3 つの障壁。強い技術力は常にチップ分野の最高峰です。1 つ目は、ストレージとコンピューティングの統合であり、これには、最下層のデバイスから回路設計、アーキテクチャ設計、ツールチェーン、そしてソフトウェア層の研究開発に至るまで、チップ製造のプロセス全体が含まれます。各層で対応する変更を行う際、各層間の適応の程度も考慮する必要があります。メモリコンピューティング統合チップの製造時にどのような技術的問題があるのか、層ごとに見てみましょう。まず、デバイスの選択に関して、メーカーは「薄氷の上を歩いている」状態です。メモリ設計がチップの歩留まりを決定し、方向性を間違えるとチップが量産されなくなる可能性があります。2つ目は回路設計レベルです。デバイスが回路レベルで利用可能になったら、ストレージ アレイの回路設計に使用する必要があります。現在、回路設計においては、インメモリ計算のための EDA ツールのガイダンスはなく、手作業で行う必要があり、操作の難易度が大幅に上昇していることは間違いありません。その直後、アーキテクチャレベルで回路ができた後、アーキテクチャ層を設計する必要があります。各回路は基本的なコンピューティング モジュールであり、アーキテクチャ全体は異なるモジュールで構成されており、メモリコンピューティング統合モジュールの設計によってチップのエネルギー効率が決まります。アナログ回路はノイズの影響を受けますし、チップもノイズの影響を受けると様々な問題が発生します。この場合、チップアーキテクトは、アナログインメモリコンピューティングのプロセス特性を十分に理解し、それに応じたアーキテクチャを設計するとともに、アーキテクチャとソフトウェア開発との適応性も考慮する必要があります。 。ソフトウェアレベルのアーキテクチャ設計が完了したら、対応するツールチェーンを開発する必要があります。(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)ストレージとコンピューティングの統合の元のモデルは従来のアーキテクチャのモデルとは異なるため、コンパイラは、すべてのコンピューティング ユニットがハードウェアにマッピングされてスムーズに実行できるように、まったく異なるストレージとコンピューティングの統合アーキテクチャに適応する必要があります。完全な技術チェーンでは、デバイス、回路設計、アーキテクチャ設計、ツールチェーン、ソフトウェア層開発の各リンクの能力をテストし、各リンクの適応能力を調整する必要があり、時間、労力、費用を消費する持久戦です。同時に、上記のリンクの動作プロセスによれば、メモリコンピューティング統合チップには経験豊富な回路設計者とチップアーキテクトが緊急に必要であることがわかります。ストレージと計算の統合の特殊性を考慮すると、ストレージと計算を統合できる企業には、人材確保の観点から次の 2 つの特性が必要です。1. リーダーには十分な勇気が必要です。デバイスの選択 (RRAM、SRAM など) とコンピューティング モード (従来のノイマン型、統合されたストレージと計算など) の選択には、明確なアイデアが必要です。なぜなら、ストレージと計算の統合は破壊的かつ革新的なテクノロジーであるため、先導する人がおらず、試行錯誤のコストが非常に高いからです。商業化を達成できる企業の創設者は、業界、大手メーカーでの豊富な経験、学歴を持っていることが多く、チームを率いて製品のイテレーションを迅速に完了させることができます。2. コアチームには、あらゆるレベルのテクノロジーにおいて経験豊富な人材を配置する必要があります。例えば、チームの中核となるアーキテクト。アーキテクトは、基礎となるハードウェアおよびソフトウェア ツールについて深い理解と認識を持ち、テクノロジーを通じてコンセプトにあるストレージとコンピューティング アーキテクチャを実現し、最終的に製品のランディングを達成できる必要があります。3. さらに、量子ビットのレポートによると、中国では回路設計、特にハイブリッド回路の分野でハイエンドの人材が不足しています。インメモリコンピューティングではアナログ回路設計が多く、チームワークを重視するデジタル回路設計に比べ、アナログ回路設計ではプロセス、デザイン、レイアウト、モデルPDK、パッケージングなどに精通した個々の設計者が必要となります。そして、この一連の才能と技術は、着陸効果を究極の目標として捉えなければなりません。着陸こそが主要な生産力です。納入時に顧客が考慮するのは、ストレージ・コンピューティング統合技術だけでなく、エネルギー効率、面積効率、使いやすさなどのストレージ・コンピューティング統合SoCの性能指標が従来と比較して十分に向上しているかどうかです。 、そしてさらに重要なのは、移行コストが手頃かどうかです。アルゴリズムのパフォーマンスを向上させるために新しいチップを選択するためにプログラミング システムを再学習する必要があり、モデルの移行の人件費が新しい GPU を購入するコストよりも高い場合、顧客は新しいチップの使用を選択しない可能性が高くなります。したがって、ストレージとコンピューティングの統合により、着陸プロセス中の移行コストを最小限に抑えられるかどうかが、顧客が製品を選択する際の重要な要素となります。大規模モデルの文脈では、メモリコンピューティング統合チップは、その低消費電力でありながら高いエネルギー効率のおかげで、チップトラックの新星になりつつあります。現在、統合預金計算市場はまだ「暁河は新興したばかり」の段階にある。しかし、ストレージと計算の統合プレーヤーはすでに三重の高い壁を築いていることは否定できず、高い技術力と確かな人材予備力を持つプレーヤーは参入すべきではありません。

2023年、AIチップ企業は3度の挑戦を受ける

2023 年、投資機関と株主は AI チップ分野の上場企業に 3 つの致命的な質問をしています。

ストレージと計算を統合したチップはもう作りましたか?

(Montage Technology に質問した投資家の情報源: 通化順金融)

メモリコンピューティング統合チップの進歩はどうですか?

(投資家ら東新株への質問元:通華順金融)

ストレージとコンピューティング チップの統合にはどのような見通しがありますか?

(恒朔株に対する投資家の質問の出典: 通化順金融)

上記の一連の質問は、ストレージと計算の統合がもはや学界や産業界に「とどまる」ものではなく、流通市場で人気があるようであることを意味します。株主や証券会社は、ストレージと計算の統合を補うために残業をしています。ストレージとコンピューティングの統合のため、従来のチップメーカーは 2023 年の初め以来、ストレージとコンピューティングの統合レイアウトを「苦しめ」てきました。

当然の疑問は、なぜ預金と計算の統合が突然これほど普及したのかということです。

7.14に新ストレージ製品OceanStor A310をリリースしたファーウェイは、独自の答えを出した。ファーウェイのデータストレージ製品ラインの社長、周岳峰氏は、汎用大規模モデルや業界大規模モデルのトレーニングと推論には多くのデータ問題があると述べた。つまり、大量のデータのクロスドメイン収集が遅い、前処理や処理におけるデータインタラクションの効率が低い、というものだ。トレーニング、および困難なデータ フロー セキュリティ。

大規模な AI モデルは、従来の AI よりも安定性が劣るなど、ストレージに新たな課題をもたらしますが、同時に、大量のデータの前処理と準備作業が発生し、ストレージに近いコンピューティング (一種のAI) が必要になります。ストレージと計算)を使用して、この問題に体系的に対処します。

では、ここで言う「大量のデータ」とはどれくらいなのでしょうか? SI Rui Insightの計算によると、ChatGPTのユーザー数は現在1日あたり1億人で、このうち5%の人が毎日同じ時間に毎秒質問すると、三峡ダムの発電量を1年近く食いつぶすことになる。

言い換えれば、大規模モデルはコンピューティング能力を猛烈に要求しており、ストレージとコンピューティングの統合に代表される新たなソリューションは、大規模モデルによってもたらされる多くの課題を解決できるということです。実際、この大型モデルはコンピューティング能力に厳しい要件を課していることに加えて、AI チップメーカーに「多量の砂糖」を与えています。

この記事では、大規模モデルの背景の下で、AI チップ メーカーにどのようなメリットがあるのかを探っていきます。 ChatGPTによって「解雇」されたストレージとコンピューティングの統合メーカーは今後どのようなパターンになるのでしょうか?

PART-01 「幸と不幸はお互いに依存する」AIチップメーカー

モックアップの風は今も吹き続けており、モックアップに関する議論はまだ真っ盛りだ。

8月初旬、中国コンピュータ連盟(CCF)人工知能会議のサブフォーラム「崑崙AIの大規模モデルコンピューティングパワーの最前線を探る」で、専門家と学者は、大規模モデルの時代には次の点で同意した。モデル、インテリジェントなコンピューティング能力は「希少資産」となっており、コンピューティング リソースをどのように有効活用し、そのメリットを最大化するかが、すべての参加者が直面しなければならない課題となっています。

GPT-3 単独で要求される計算能力の量に関しては、控えめな状況下では、三峡ダムは以下を満たすために徹夜で「稼働」する必要があります。

同時にオンラインに 1 億人がいると仮定すると、そのうちの 5% が毎日同じ時間に毎秒質問し、それぞれが 30 個のトークンを占有し、推論コンピューティング能力を提供するには 1,530 万個の H100 チップが必要になります。各 H100 の消費電力は 750 W です。1 日 10 時間稼働した場合、これらの H100 チップが配置されているデータセンターの年間消費電力は 840 億 kWh に達し、三峡ダムの年間発電量は 840 億 kWh に達します。 882億kW*h。

AI チップ メーカーをさらに不安にさせるのは、これが推論段階の大規模な ChatGPT モデルの消費電力にすぎないことです。

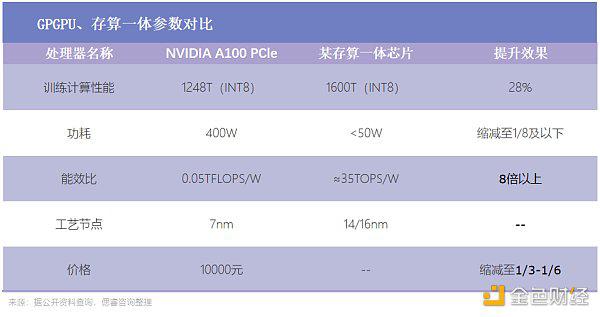

その結果、統合ストレージとコンピューティング、チップレット、HBM などの一連の新しいソリューションがメーカーによって発掘されています。その中で、ストレージとコンピューティングの統合は、従来のフォン・ノイマン・アーキテクチャの下でのストレージの壁を打ち破ったため、実際にコスト削減と効率向上を実現し、今年の「Ziweixing」となりました。

(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)

AI チップ メーカーに息吹を与えた新たなソリューションの出現に加え、このビッグ モデルはチップ メーカー、特に新興チップ メーカーに朗報ももたらします。それは、ソフトウェア エコロジーの重要性が低下しているということです。

初期のテクノロジーが十分に成熟していなかったとき、研究者は特定の問題を解決することから始めることしかできず、パラメーターが 100 万未満の小さなモデルが生まれました。たとえば、Google が所有する AI 企業 DeepMind は、AlphaGO が何百万人もの人間のプロ プレイヤーのチェスの手順について特別な「学習」を行うことを許可しています。

小型モデルが増えた後は、チップの適応などのハードウェアの問題が差し迫っている。したがって、Nvidia が統合エコロジカル CUDA を発表したとき、GPU+CUDA はすぐにコンピューター サイエンス コミュニティの認識を獲得し、人工知能開発の標準構成になりました。

現在、次々と登場している大型モデルはマルチモーダル機能を備え、文字、画像、プログラミングなどを扱え、オフィス、教育、医療など複数の垂直分野もカバーできます。これは、主流のエコロジーに適応することが唯一の選択肢ではないことも意味します。大型モデル用のチップの需要が急増しているとき、チップメーカーは、これまでは 1 ~ 2 個の大型モデルに適応するだけで、複数の小型モデルの注文を完了できた可能性があります。 。

言い換えれば、ChatGPTの登場は新興チップメーカーにコーナーで追い抜く機会を提供することになる。これは、AIチップ市場構造が大きく変化することを意味します。もはや個別メーカーの個展ではなく、複数のイノベーターによるグループプレイとなるでしょう。

コンピューティング能力が不足し、主流のエコロジーに適応することがもはや必須ではなくなったとき、ストレージとコンピューティングの統合はその光を隠すことはほとんどできません。現時点で、投資するかどうか、そしてどれだけ投資するかがAIチップメーカーが直面する第二の問題となっている。

この点に関して、「経験豊富な」チップ大手 NVIDIA が長年にわたって与えた答えは、イノベーションに勇気を持って多額の投資を行うことです。

新興技術の研究開発を行うすべてのメーカーは、技術的探求の障害や下流メーカーの意見の相違など、さまざまなレベルで問題に直面することは間違いありません。初期の段階で、将来の発展傾向を最初に予測し、勇気を出して探索のステップを踏み出し、合理的なリソースを投入して挑戦した人が、チャンスを掴むことができます。

データセンターの波がまだ圧倒的に押し寄せておらず、人工知能トレーニングがまだニッチな分野であるとき、Nvidia は汎用コンピューティング GPU と統合プログラミング ソフトウェア CUDA の開発に多額の投資を行ってきました。これは Nvidia にとって良い仕事です。コンピューティング プラットフォーム。

当時、GPU をプログラマブルにすることは「無駄で損」でした。性能が 2 倍になるかどうかはわかりませんが、製品開発は 2 倍になります。このため、喜んでお金を払う顧客はいません。しかし、単機能のグラフィックス プロセッサは長期的な解決策ではないと予測した Nvidia は、すべての製品ラインに CUDA を適用することを決定しました。

Xindongxi と Nvidia China のエンジニアリングおよびソリューション担当シニア ディレクターである Lai Junjie 博士とのインタビューの中で、Lai Junjie 氏は次のように述べました。「コンピューティング プラットフォームのビジョンのために、Huang Renxun 氏は初期の段階で Nvidia の多くのリソースを迅速に動員しました。日々。"

先見性と多額の投資により、2012 年に Nvidia はイノベーター賞を受賞しました: 2012 年、深層学習アルゴリズムのコンピューティング パフォーマンスは学界にセンセーションを巻き起こしました。高度なコンピューティング、より多用途で使いやすい生産性ツールとして、 GPU+CUDA は急速に普及し、コンピュータ サイエンス コミュニティでは人工知能開発の「標準構成」になりました。

大きなコンピューティング能力を備えた AI チップの歩みの中で、統合ストレージおよびコンピューティング チップは独自の「黄金期」を迎えており、事前の投資が正しい答えです。

PART-02 非技術者、経済的に裕福な方は入場しないでください

ストレージとコンピューティングの統合によるさまざまな利点を考慮して、現段階ではストレージとコンピューティング チップを統合するプレーヤーの陣営が成長しています。

(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)

CIRUI Insightの不完全な統計によると、2019年以降、ほとんどの新しいAIチップメーカーはストレージとコンピューティングを統合しています。2019年から2021年には20社の新しいAIチップメーカーがあり、そのうち10社はデポジットと計算の統合ルートを選択しています。

これらはすべて、ストレージとコンピューティングの統合が GPGPU、ASIC、その他のアーキテクチャに続く新星になることを示しています。そして、この新しいスター、誰もがそれを選ぶことができるわけではありません。

学界、産業界、資本がストレージとコンピューティングの統合について一致して楽観的である状況下では、強力な技術力、堅実な人材の確保、移行コストの受け入れの正確な制御が、業界の競争力を維持するための鍵となります。新規参入者にとっての 3 つの障壁。

強い技術力は常にチップ分野の最高峰です。

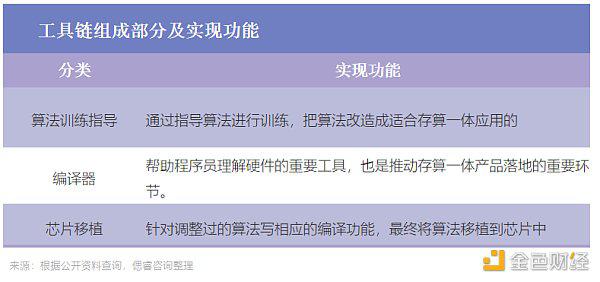

1 つ目は、ストレージとコンピューティングの統合であり、これには、最下層のデバイスから回路設計、アーキテクチャ設計、ツールチェーン、そしてソフトウェア層の研究開発に至るまで、チップ製造のプロセス全体が含まれます。各層で対応する変更を行う際、各層間の適応の程度も考慮する必要があります。

メモリコンピューティング統合チップの製造時にどのような技術的問題があるのか、層ごとに見てみましょう。

まず、デバイスの選択に関して、メーカーは「薄氷の上を歩いている」状態です。メモリ設計がチップの歩留まりを決定し、方向性を間違えるとチップが量産されなくなる可能性があります。

2つ目は回路設計レベルです。デバイスが回路レベルで利用可能になったら、ストレージ アレイの回路設計に使用する必要があります。現在、回路設計においては、インメモリ計算のための EDA ツールのガイダンスはなく、手作業で行う必要があり、操作の難易度が大幅に上昇していることは間違いありません。

その直後、アーキテクチャレベルで回路ができた後、アーキテクチャ層を設計する必要があります。各回路は基本的なコンピューティング モジュールであり、アーキテクチャ全体は異なるモジュールで構成されており、メモリコンピューティング統合モジュールの設計によってチップのエネルギー効率が決まります。アナログ回路はノイズの影響を受けますし、チップもノイズの影響を受けると様々な問題が発生します。

この場合、チップアーキテクトは、アナログインメモリコンピューティングのプロセス特性を十分に理解し、それに応じたアーキテクチャを設計するとともに、アーキテクチャとソフトウェア開発との適応性も考慮する必要があります。 。ソフトウェアレベルのアーキテクチャ設計が完了したら、対応するツールチェーンを開発する必要があります。

(写真出典: Cirui Insights の「AI ビッグ コンピューティング パワー チップ産業レポート - 数百隻の戦艦、最初のイノベーター」)

ストレージとコンピューティングの統合の元のモデルは従来のアーキテクチャのモデルとは異なるため、コンパイラは、すべてのコンピューティング ユニットがハードウェアにマッピングされてスムーズに実行できるように、まったく異なるストレージとコンピューティングの統合アーキテクチャに適応する必要があります。

完全な技術チェーンでは、デバイス、回路設計、アーキテクチャ設計、ツールチェーン、ソフトウェア層開発の各リンクの能力をテストし、各リンクの適応能力を調整する必要があり、時間、労力、費用を消費する持久戦です。

同時に、上記のリンクの動作プロセスによれば、メモリコンピューティング統合チップには経験豊富な回路設計者とチップアーキテクトが緊急に必要であることがわかります。

ストレージと計算の統合の特殊性を考慮すると、ストレージと計算を統合できる企業には、人材確保の観点から次の 2 つの特性が必要です。

リーダーには十分な勇気が必要です。デバイスの選択 (RRAM、SRAM など) とコンピューティング モード (従来のノイマン型、統合されたストレージと計算など) の選択には、明確なアイデアが必要です。なぜなら、ストレージと計算の統合は破壊的かつ革新的なテクノロジーであるため、先導する人がおらず、試行錯誤のコストが非常に高いからです。商業化を達成できる企業の創設者は、業界、大手メーカーでの豊富な経験、学歴を持っていることが多く、チームを率いて製品のイテレーションを迅速に完了させることができます。

コアチームには、あらゆるレベルのテクノロジーにおいて経験豊富な人材を配置する必要があります。例えば、チームの中核となるアーキテクト。アーキテクトは、基礎となるハードウェアおよびソフトウェア ツールについて深い理解と認識を持ち、テクノロジーを通じてコンセプトにあるストレージとコンピューティング アーキテクチャを実現し、最終的に製品のランディングを達成できる必要があります。

さらに、量子ビットのレポートによると、中国では回路設計、特にハイブリッド回路の分野でハイエンドの人材が不足しています。インメモリコンピューティングではアナログ回路設計が多く、チームワークを重視するデジタル回路設計に比べ、アナログ回路設計ではプロセス、デザイン、レイアウト、モデルPDK、パッケージングなどに精通した個々の設計者が必要となります。

そして、この一連の才能と技術は、着陸効果を究極の目標として捉えなければなりません。着陸こそが主要な生産力です。納入時に顧客が考慮するのは、ストレージ・コンピューティング統合技術だけでなく、エネルギー効率、面積効率、使いやすさなどのストレージ・コンピューティング統合SoCの性能指標が従来と比較して十分に向上しているかどうかです。 、そしてさらに重要なのは、移行コストが手頃かどうかです。

アルゴリズムのパフォーマンスを向上させるために新しいチップを選択するためにプログラミング システムを再学習する必要があり、モデルの移行の人件費が新しい GPU を購入するコストよりも高い場合、顧客は新しいチップの使用を選択しない可能性が高くなります。

したがって、ストレージとコンピューティングの統合により、着陸プロセス中の移行コストを最小限に抑えられるかどうかが、顧客が製品を選択する際の重要な要素となります。

大規模モデルの文脈では、メモリコンピューティング統合チップは、その低消費電力でありながら高いエネルギー効率のおかげで、チップトラックの新星になりつつあります。現在、統合預金計算市場はまだ「暁河は新興したばかり」の段階にある。

しかし、ストレージと計算の統合プレーヤーはすでに三重の高い壁を築いていることは否定できず、高い技術力と確かな人材予備力を持つプレーヤーは参入すべきではありません。